Un modello di sintesi delle immagini open source appena rilasciato chiamato Stable Diffusion consente a chiunque abbia un PC e una GPU decente di evocare quasi tutte le realtà visive che si possono immaginare. Può imitare praticamente qualsiasi stile visivo e, se gli dai una frase descrittiva, i risultati appaiono sullo schermo come per magia.

Alcuni artisti sono deliziati dalla prospettiva, altri non ne sono contenti e la società in generale sembra ancora in gran parte ignara della rivoluzione tecnologica in rapida evoluzione che sta avvenendo attraverso le comunità su Twitter, Discord e Github. La sintesi delle immagini porta probabilmente implicazioni grandi quanto l’invenzione della fotocamera o forse la creazione dell’arte visiva stessa.

Anche il nostro senso della storia potrebbe essere messo in gioco, a seconda di come le cose si muoveranno nei prossimi mesi. In ogni caso, Stable Diffusion sta guidando una nuova ondata di strumenti creativi di deep learning pronti a rivoluzionare la creazione di media visivi.

L’ascesa della sintesi di immagini di deep learning

Stable Diffusion nasce da un’idea di Emad Mostaque, un ex gestore di hedge fund con sede a Londra il cui obiettivo è portare nuove applicazioni di deep learning alle masse attraverso la sua azienda, Stability AI. Ma le radici della moderna sintesi di immagini risalgono al 2014 e Stable Diffusion non è stato il primo modello di sintesi di immagini (ISM) a fare scalpore quest’anno.

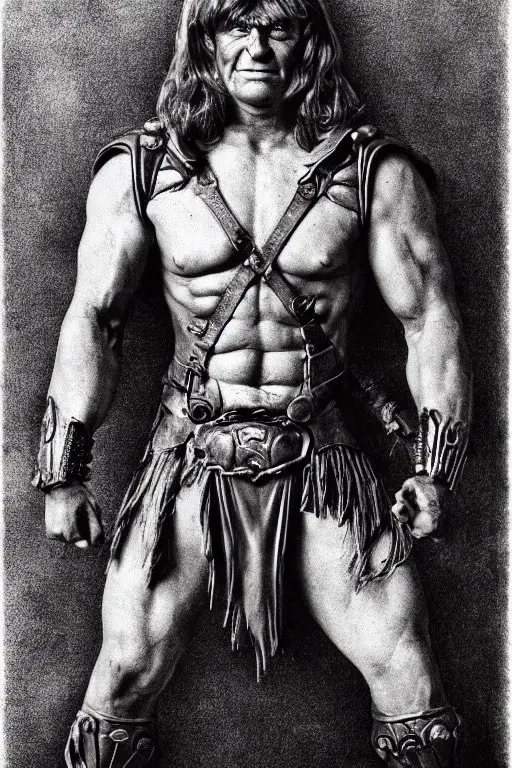

Nell’aprile 2022, OpenAI ha annunciato DALL-E 2, che ha scioccato i social media con la sua capacità di trasformare una scena scritta a parole (chiamata “prompt”) in una miriade di stili visivi che possono essere fantastici, fotorealistici o persino banali. Le persone con accesso privilegiato allo strumento chiuso hanno generato astronauti a cavallo, orsacchiotti che compravano pane nell’antico Egitto, nuove sculture nello stile di artisti famosi e molto altro.

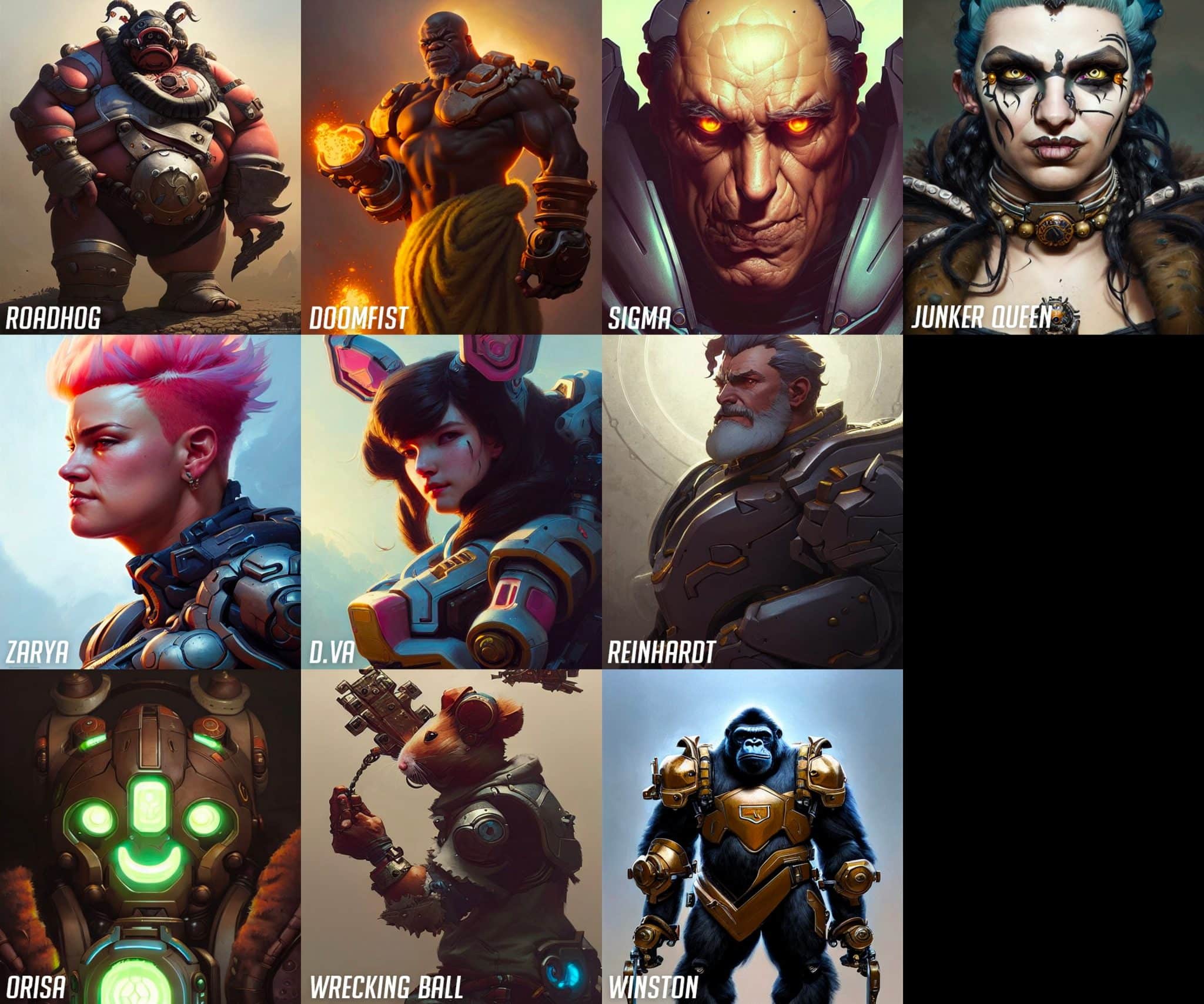

Non molto tempo dopo DALL-E 2, Google e Meta hanno annunciato il proprio modelli di intelligenza artificiale da testo a immagine. MidJourney, disponibile come server Discord da marzo 2022 e aperto al pubblico pochi mesi dopo, addebita l’accesso e ottiene effetti simili ma con una qualità più pittorica e illustrativa come impostazione predefinita.

Poi c’è Stable Diffusion. Il 22 agosto, Stability AI ha rilasciato il suo modello di generazione di immagini open source che probabilmente corrisponde a DALL-E 2 in termini di qualità. Ha anche lanciato il proprio sito web commerciale, chiamato DreamStudio, che vende l’accesso al tempo di calcolo per la generazione di immagini con Stable Diffusion. A differenza di DALL-E 2, chiunque può usarlo e poiché il codice Stable Diffusion è open source, i progetti possono essere costruiti con poche restrizioni.

Solo nell’ultima settimana sono sorti dozzine di progetti che portano Stable Diffusion in direzioni radicalmente nuove. E le persone hanno ottenuto risultati inaspettati usando una tecnica chiamata “img2img” che ha “aggiornato” la grafica dei giochi MS-DOS, convertito la grafica di Minecraft in realistica, trasformato una scena di Aladino in 3D, tradotto scarabocchi infantili in ricche illustrazioni e molto altro ancora.

La sintesi delle immagini può portare la capacità di visualizzare idee in modo ricco a un pubblico di massa, abbassando le barriere all’ingresso e accelerando anche le capacità degli artisti che abbracciano la tecnologia, proprio come ha fatto Adobe Photoshop negli anni ’90. Puoi eseguire tu stesso Stable Diffusion localmente se segui una serie di passaggi non semplicissimi.

Su un PC Windows con una GPU Nvidia RTX 3060 da 12 GB, può generare immagini da 512×512 in circa 10 secondi. Su un 3090 Ti, quel tempo scende a quattro secondi per immagine. Anche le interfacce continuano a evolversi rapidamente, passando da semplici interfacce a riga di comando e notebook Google Colab, a GUI front-end più raffinate (ma comunque complesse), con interfacce migliori in arrivo.

Quindi, se non sei incline tecnicamente, tieniti forte: sono in arrivo soluzioni più semplici. E se tutto il resto fallisce, puoi provare una demo online.

Stable Diffusion: come funziona

In generale, la maggior parte della recente ondata di ISM utilizza una tecnica chiamata diffusione latente. Fondamentalmente, il modello impara a riconoscere forme familiari in un campo di puro rumore, quindi mette gradualmente a fuoco quegli elementi se corrispondono alle parole nel prompt.

Per iniziare, una persona o un gruppo che addestra il modello raccoglie immagini con metadati (come tag alt e didascalie trovati sul Web) e forma un set di dati di grandi dimensioni. Nel caso di Stable Diffusion, Stability AI utilizza un sottoinsieme del set di immagini LAION-5B, che è fondamentalmente un’enorme immagine di 5 miliardi di immagini accessibili pubblicamente su Internet.

Un’analisi recente del set di dati mostra che molte delle immagini provengono da siti come Pinterest, DeviantArt e persino Getty Images. Di conseguenza, Stable Diffusion ha assorbito gli stili di molti artisti viventi e alcuni di loro si sono espressi con forza contro la pratica. Successivamente, il modello si allena sul set di dati dell’immagine utilizzando un banco di centinaia di GPU di fascia alta come Nvidia A100.

Secondo Mostaque, Stable Diffusion è costato $ 600.000 per allenarsi finora (le stime dei costi di formazione per altri ISM variano in genere nell’ordine di milioni di dollari). Durante il percorso formativo, il modello associa le parole alle immagini grazie a una tecnica chiamata CLIP (Contrastive Language–Image Pre-training), inventata da OpenAI e annunciata proprio lo scorso anno.

Attraverso la formazione, un ISM che utilizza la diffusione latente apprende le associazioni statistiche su dove appartengono di solito determinati pixel colorati in relazione tra loro per ciascuna materia. Quindi non necessariamente “capisce” la loro correlazione ad alto livello, ma i risultati possono comunque essere sbalorditivi e sorprendenti, facendo inferenze e combinazioni di stile che sembrano molto intelligenti.

Al termine del processo di addestramento, il modello non duplica mai alcuna immagine nel set di origine, ma può invece creare nuove combinazioni di stili in base a ciò che ha appreso. I risultati possono essere deliziosi e assurdamente divertenti.

Al momento, Stable Diffusion non si preoccupa se una persona ha tre braccia, due teste o sei dita per mano, quindi a meno che tu non sia un mago nel creare i prompt di testo necessari per generare grandi risultati (che gli artisti dell’IA a volte chiamano “prompt engineering“), probabilmente dovrai generare molte immagini e scegliere le migliori.

Tieni presente che più un prompt corrisponde alle didascalie per le immagini conosciute nel set di dati, più è probabile che otterrai il risultato desiderato. In futuro, è probabile che i modelli migliorino abbastanza da ridurre la necessità di selezionare queste piccole cose, o una sorta di filtro interno farà la scelta per te.

Le preoccupazioni etiche e legali abbondano

Come accennato in precedenza, il rilascio pubblico di Stable Diffusion ha sollevato campanelli d’allarme tra le persone che temono il suo impatto culturale ed economico. A differenza di DALL-E 2, i dati di allenamento di Stable Diffusion (i “pesi”) possono essere utilizzati da chiunque senza restrizioni rigide.

La versione ufficiale di Stable Diffusion (e DreamStudio) include filtri “NSFW” automatici (nudità) e una filigrana di tracciamento invisibile incorporata nelle immagini, ma queste restrizioni possono essere facilmente aggirate nel codice open source.

Ciò significa che Stable Diffusion può essere utilizzato per creare immagini che OpenAI attualmente blocca con DALL-E 2: propaganda, immagini violente, pornografia, immagini che potenzialmente violano il copyright aziendale, deepfake di celebrità e altro ancora. In effetti, esistono già alcuni server Discord privati dedicati all’output pornografico del modello.

Per essere chiari, la licenza di Stable Diffusion proibisce ufficialmente molti di questi usi, ma con il codice e i pesi allo stato brado, l’applicazione si rivelerà molto difficile, se non impossibile. Quando gli sono state presentate queste preoccupazioni, Mostaque ha affermato di ritenere che i vantaggi di avere questo tipo di strumento open-source dove può essere esaminato da tutti, superano i potenziali svantaggi.

In una breve intervista, ci ha detto: “Crediamo nella responsabilità e nel libero arbitrio individuali. Abbiamo incluso una politica di utilizzo etico e strumenti per mitigare i danni”. Inoltre, Stable Diffusion ha attirato l’ira degli artisti su Twitter per la capacità della modella di imitare lo stile degli artisti viventi, come accennato in precedenza. E nonostante le affermazioni di alcuni tweet virali, Stability AI non ha mai pubblicizzato questa capacità.

Uno dei tweet più condivisi è stato erroneamente estratto da uno studio indipendente condotto da un ricercatore di intelligenza artificiale. Nella ricerca di dati, il set di immagini utilizzato per addestrare Stable La diffusione include milioni di opere d’arte raccolte da artisti viventi senza aver consultato gli artisti, il che solleva profonde questioni etiche sulla paternità e sul copyright.

Raschiare i dati sembra lecito dai precedenti legali statunitensi, ma si potrebbe sostenere che la legge potrebbe essere in ritardo rispetto a una tecnologia in rapida evoluzione che capovolge le precedenti ipotesi su come potrebbero essere utilizzati i dati pubblici.

Di conseguenza, se la tecnologia di sintesi delle immagini verrà adottata dalle grandi aziende in futuro (che potrebbe arrivare presto: “Abbiamo un rapporto di collaborazione con Adobe”, afferma Mostaque), le aziende potrebbero formare i propri modelli sulla base di dati “puliti”, set che includeranno contenuti concessi in licenza, contenuti con attivazione e immagini di pubblico dominio per evitare alcuni di questi problemi etici, anche se l’utilizzo di Internet scrape è tecnicamente legale.

Hanno chiesto chiesto a Mostaque se avesse dei piani in questo senso e lui ha risposto: “Stable sta lavorando su una gamma di modelli. Tutti i modelli, nostri e dei nostri collaboratori, sono legali all’interno delle loro giurisdizioni”.

Un altro problema con i modelli di diffusione di tutti i fornitori è il pregiudizio culturale. Dal momento che questi ISM attualmente funzionano raschiando Internet alla ricerca di immagini e dei relativi metadati, apprendono gli stereotipi sociali e culturali presenti nel set di dati.

Ad esempio, all’inizio della versione beta di Stable Diffusion sul suo server Discord, i tester hanno scoperto che quasi tutte le richieste di una “bella donna” implicavano nudità non intenzionali di qualche tipo, il che riflette il modo in cui la società occidentale raffigura spesso le donne su Internet.

Altri stereotipi culturali e razzisti abbondano nei dati di formazione ISM, quindi i ricercatori avvertono che non dovrebbe essere utilizzato in un ambiente di produzione senza salvaguardie significative in atto, che è probabilmente una delle ragioni per cui altri potenti modelli come DALLE-2 e Imagen di Google non sono ancora ampiamente disponibile al pubblico.

Mentre le preoccupazioni sulla qualità del set di dati e sui pregiudizi echeggiano fortemente tra alcuni ricercatori di intelligenza artificiale, Internet rimane la più grande fonte di immagini con metadati allegati. Questa raccolta di dati è liberamente accessibile, quindi sarà sempre un bersaglio allettante per gli sviluppatori di ISM.

Il tentativo di scrivere manualmente didascalie descrittive per milioni o miliardi di immagini per un set di dati etici nuovo di zecca non è probabilmente economicamente fattibile al momento, quindi sono i dati fortemente distorti su Internet che stanno attualmente rendendo possibile questa tecnologia.

Dal momento che non esiste una visione del mondo universale tra le culture, in che misura i modelli di sintesi delle immagini filtrino o interpretino determinate idee probabilmente rimarrà un giudizio di valore tra le diverse comunità che utilizzeranno la tecnologia in futuro.

Quello che verrà dopo

Se le tendenze storiche nell’informatica sono un monito, la probabilità che ciò che ora richiede una GPU potente, sarà alla fine possibile su uno smartphone tascabile, è molto alta. “È probabile che Stable Diffusion possa funzionare su uno smartphone entro un anno”, ci ha detto Mostaque. Inoltre, nuove tecniche consentiranno di addestrare questi modelli su attrezzature meno costose nel tempo. Presto potremmo assistere a un’esplosione della produzione creativa alimentata dall’IA.

Stable Diffusion e altri modelli stanno già iniziando a creare e manipolare video dinamici, quindi aspettati la generazione di video fotorealistici tramite messaggi di testo in breve tempo. Da lì, è logico estendere queste capacità ad audio e musica, videogiochi in tempo reale ed esperienze 3D VR. Presto, l’IA avanzata potrebbe fare la maggior parte del lavoro pesante creativo con pochi suggerimenti.

Immagina intrattenimento illimitato generato in tempo reale, su richiesta. “Mi aspetto che sia completamente multimodale”, ha detto Mostaque, “così puoi creare qualsiasi cosa tu possa immaginare, come l’esperienza del ponte ologrammi di Star Trek”.

Gli ISM usano anche una forma drastica di compressione delle immagini: Stable Diffusion prende centinaia di milioni di immagini e ne comprime la conoscenza in un file con pesi di 4,2 GB. Con il seed e le impostazioni corrette, alcune immagini generate possono essere riprodotte in modo deterministico. Si potrebbe immaginare di utilizzare una variante di questa tecnologia in futuro per comprimere, ad esempio, un film 8K in pochi megabyte di testo.

Una volta che questo è il caso, chiunque potrebbe anche comporre i propri lungometraggi in questo modo. Le implicazioni di questa tecnologia stanno appena iniziando ad essere esplorate, quindi potrebbe portarci in nuove direzioni selvagge che non possiamo prevedere al momento.

I modelli di sintesi di immagini realistici sono potenzialmente pericolosi per ragioni già menzionate, come la creazione di propaganda o disinformazione, manomissione della storia, accelerazione della divisione politica, consentire attacchi di personaggi e rappresentazione e distruzione del valore legale di prove fotografiche o video.

Nel futuro basato sull’intelligenza artificiale, come faremo a sapere se un qualsiasi elemento multimediale prodotto in remoto proviene da una fotocamera reale o se stiamo effettivamente comunicando con un vero essere umano? Su queste domande, Mostaque è ampiamente fiducioso. “Ci saranno nuovi sistemi di verifica in atto e rilasci aperti come questo sposteranno il dibattito pubblico e lo sviluppo di questi strumenti”, ha affermato.

È più facile a dirsi che a farsi, ovviamente. Ma è anche facile avere paura delle cose nuove. Nonostante i nostri migliori sforzi, è difficile sapere esattamente come la sintesi delle immagini e altre tecnologie basate sull’intelligenza artificiale ci influenzeranno su scala sociale senza vederle ampiamente utilizzate. Alla fine, l’umanità si adatterà, anche se le nostre strutture culturali finiranno per cambiare radicalmente nel processo.

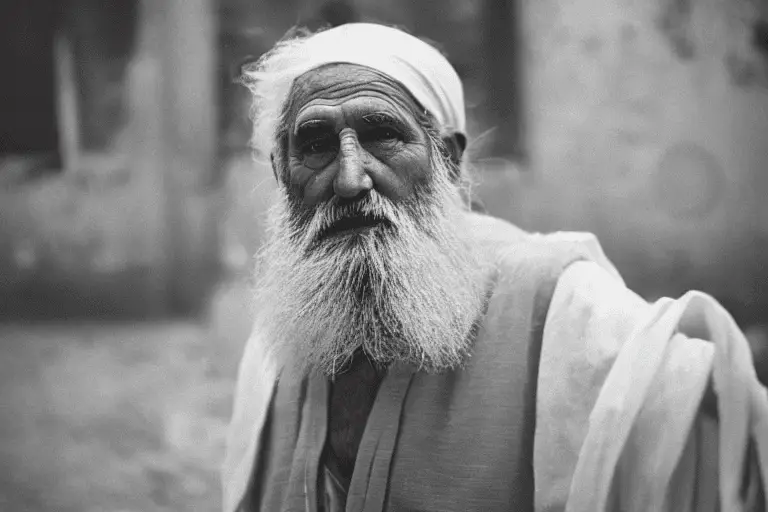

È già successo, motivo per cui il filosofo greco antico Eraclito disse: “L’unica costante è il cambiamento”. In effetti, c’è una sua foto che lo dice ora, grazie a Stable Diffusion.