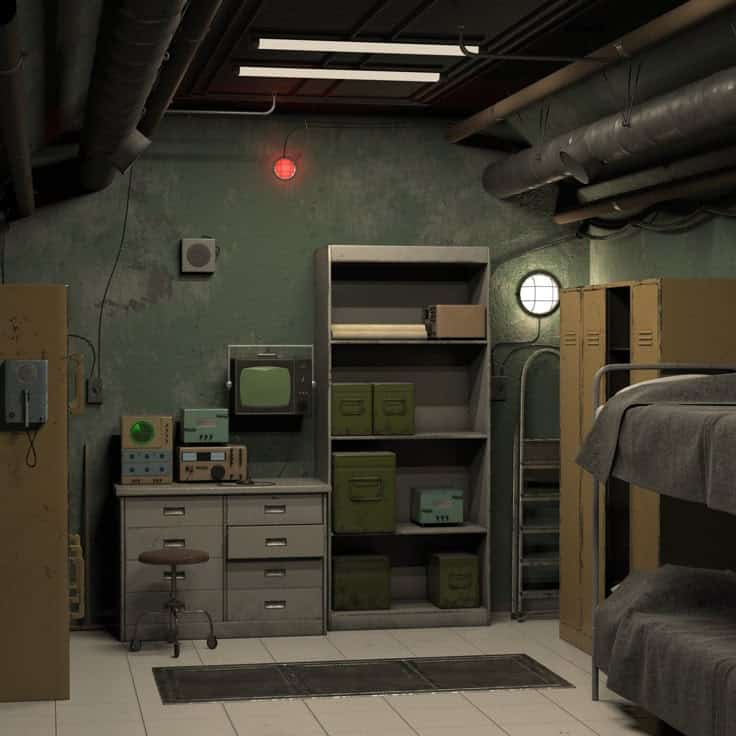

“Prima di rilasciare l’AGI, costruiremo un bunker. Ovviamente sarà opzionale entrarci.”

No, non è una battuta. È quello che avrebbe detto Ilya Sutskever, ex chief scientist di OpenAI, a un gruppo di colleghi nell’estate del 2023.

E se ti sembra la trama di una serie Netflix stile Black Mirror, sappi che invece è tutto vero. O almeno: è quello che raccontano le fonti interne a OpenAI.

AGI, rapture e paranoia high-tech

AGI sta per Artificial General Intelligence: l’intelligenza artificiale “definitiva”, capace di superare l’uomo in tutto.

Non ci siamo ancora arrivati? Forse. Ma per Sutskever era già tempo di prepararsi all’apocalisse digitale.

Durante un meeting, qualcuno racconta che il cofondatore avrebbe detto:

“Una volta che saremo tutti dentro al bunker…”

“Aspetta, il bunker?”

“Certo. Lo costruiremo prima di rilasciare l’AGI.”

Tutto detto con la calma di chi ti annuncia che domani pioverà.

Il bunker era solo l’inizio

Secondo quanto riportato da The Atlantic, Sutskever non era solo preoccupato. Era ossessionato.

Credeva che la creazione dell’AGI avrebbe portato a una sorta di “rapture” (sì, come l’ascesa mistica).

E non era il solo: un piccolo gruppo dentro OpenAI sembrava vedere l’AGI come una divinità nascente.

“C’è chi pensa che l’AGI porterà a una forma di salvezza finale,” ha detto uno dei ricercatori. “Letteralmente.”

Spoiler: è anche il tipo che pensava che alcuni modelli fossero “un po’ coscienti”

Già nel 2022, prima che ChatGPT esplodesse nel mondo, Sutskever dichiarava che alcuni modelli AI erano “leggermente coscienti”.

E se ti sembrava esagerato allora… ora sai che stava anche progettando un rifugio anti-AGI.

Non proprio il classico piano B da weekend.

La storia dietro il colpo di scena (e il fallimento)

Questa ossessione per l’AGI ha portato Sutskever a fare qualcosa di storico: guidare il colpo di stato che ha cacciato Sam Altman da OpenAI nel novembre 2023.

Una mossa clamorosa, che però si è sgonfiata in pochi giorni.

I dipendenti hanno preso le parti di Altman. Sutskever ha fatto marcia indietro.

Risultato? Altman è tornato. Lui se n’è andato.

E dentro OpenAI, quel momento viene ormai chiamato “The Blip”, tipo glitch nella timeline.

Ma cosa ci dice tutto questo sull’AGI?

Che anche i migliori scienziati hanno paura di ciò che stanno costruendo.

Che la corsa all’AGI non è solo una sfida tecnica, ma anche psicologica, politica e quasi spirituale.

E che forse, prima di costruire bunker, sarebbe il caso di costruire qualche regola in più.

E tu? Ti metteresti mai in un bunker anti-AGI o preferisci affrontare l’intelligenza artificiale a viso aperto?

→ Seguici su Instagram per altre storie assurde ma vere dal mondo dell’AI che (forse) ci dominerà.