Microsoft ha rilasciato un framework di automazione open access chiamato PyRIT (abbreviazione di Python Risk Identification Tool), disponibile su GitHub, per identificare in modo proattivo i rischi nei sistemi di intelligenza artificiale (IA) generativa.

Come funzionerà PyRIT di Microsoft e quale ruolo avrà

Lo strumento di red teaming è progettato per “consentire a ogni organizzazione in tutto il mondo di innovare in modo responsabile con gli ultimi progressi dell’intelligenza artificiale“, ha dichiarato Ram Shankar Siva Kumar, responsabile del red team di AI di Microsoft.

L’azienda ha affermato che PyRIT può essere utilizzato per valutare la robustezza degli endpoint del modello di linguaggio esteso (LLM) contro diverse categorie di danni, come la fabbricazione (ad esempio, allucinazione), l’abuso (ad esempio, pregiudizio) e i contenuti vietati (ad esempio, molestie).

Può anche essere utilizzato per identificare danni alla sicurezza che vanno dalla generazione di malware al jailbreaking, così come danni alla privacy come il furto di identità.

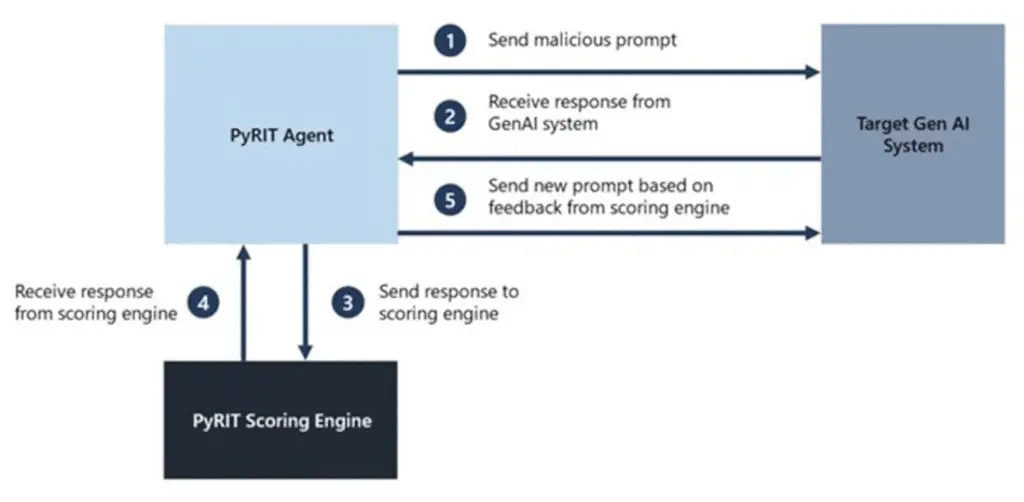

PyRIT è dotato di cinque interfacce: target, dataset, motore di valutazione, la capacità di supportare diverse strategie di attacco e l’incorporazione di un componente di memoria che può assumere la forma di JSON o di un database per memorizzare le interazioni di input e output intermedie.

Il motore di valutazione offre anche due opzioni diverse per valutare gli output dal sistema AI target, consentendo ai red teamers di utilizzare un classificatore di apprendimento automatico classico o sfruttare un endpoint LLM per l’autovalutazione.

“L’obiettivo è consentire ai ricercatori di avere una base di valutazione di quanto bene il loro modello e l’intera pipeline di inferenza stiano facendo contro diverse categorie di danni e poter confrontare tale base con le future iterazioni del loro modello“, ha detto Microsoft.

Microsoft ha successivamente aggiunto che “Ciò consente loro di avere dati empirici su quanto bene il loro modello stia facendo oggi e individuare eventuali degradazioni delle prestazioni basate su futuri miglioramenti.”

Detto questo, la grande azienda tecnologica sottolinea con attenzione che PyRIT non è un sostituto per il red teaming manuale dei sistemi AI generativi e che integra l’esperienza di dominio esistente di un red team, bensì un aiuto in più rispetto a quello umano che è il motore principale.

In altre parole, lo strumento è pensato per evidenziare i “punti caldi” dei rischi generando prompt che potrebbero essere utilizzati per valutare il sistema AI e individuare aree che richiedono ulteriori indagini.

Microsoft ha inoltre riconosciuto che il red teaming dei sistemi AI generativi richiede un’indagine simultanea dei rischi di sicurezza e di IA responsabile e che l’esercizio è più probabilistico, sottolineando anche le ampie differenze nelle architetture dei sistemi AI generativi.

“La sondaggio manuale, sebbene sia dispendioso in termini di tempo, è spesso necessario per identificare potenziali punti ciechi“, ha dichiarato Siva Kumar. “L’automazione è necessaria per la scalabilità, ma non sostituisce la sondaggio manuale.”

Lo sviluppo arriva mentre Protect AI ha rivelato diverse vulnerabilità critiche nelle popolari piattaforme di catena di approvvigionamento AI come ClearML, Hugging Face, MLflow e Triton Inference Server che potrebbero risultare nell’esecuzione di codice arbitrario e nella divulgazione di informazioni sensibili.

Conclusione

In conclusione, il rilascio di PyRIT da parte di Microsoft rappresenta un passo significativo verso l’identificazione in tempo reale dei rischi nei sistemi di intelligenza artificiale generativa, simile a Malwarebytes in tempo reale, per capirci, con la differenza che invece di identificare i malware identifica i problemmi delle intelligenze artificiali generative.

Sebbene il framework offra strumenti per valutare la robustezza e individuare potenziali minacce, è importante sottolineare che PyRIT non sostituisce il ruolo cruciale del red teaming manuale. L’automazione, sebbene essenziale per la scalabilità, deve essere complementare all’expertise umana nella valutazione dei rischi, garantendo un approccio bilanciato e responsabile all’innovazione nell’ambito dell’intelligenza artificiale.