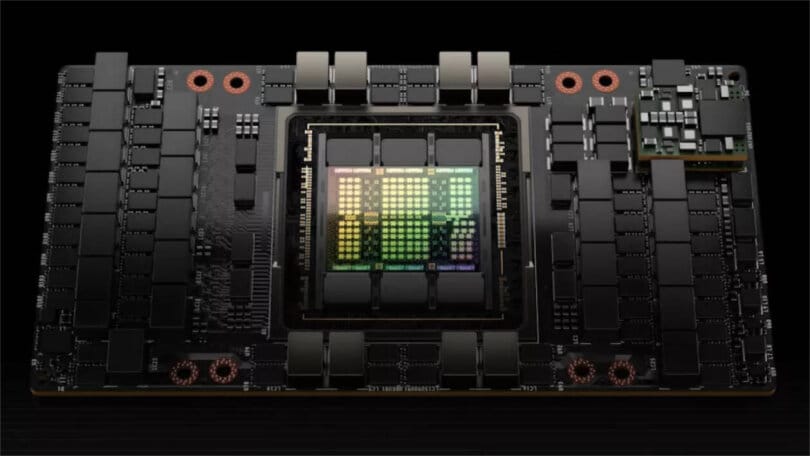

Il processore Nvidia H100 “Hopper”, che l’amministratore delegato dell’azienda Jensen Huang ha presentato a marzo, dovrebbe iniziare la spedizione il prossimo trimestre. Il processore ha ben 80 miliardi di transistor e misura 814 millimetri quadrati, che è grande quasi quanto fisicamente possibile con le moderne apparecchiature per la produzione di chip.

L’H100 compete con processori AI enormi e assetati di energia come l’MI250X di AMD, il TPU v4 di Google e il prossimo Ponte Vecchio di Intel. Tali chip sono dei giganti che si trovano più spesso nell’ambiente preferito per i sistemi di formazione AI, data center pieni di rack di apparecchiature informatiche e allacciati con grossi cavi di alimentazione in rame.

Il nuovo chip incarna l’evoluzione di Nvidia da progettista di unità di elaborazione grafica utilizzate per i videogiochi a potenza di intelligenza artificiale. L’azienda lo ha fatto adattando le GPU per la particolare matematica dell’IA, come la moltiplicazione di matrici di numeri.

I circuiti per accelerare l’IA stanno diventando sempre più importanti man mano che la tecnologia arriva a tutto, dagli iPhone ad Aurora, che dovrebbe essere il supercomputer più veloce del mondo. I chip come l’H100 sono fondamentali per velocizzare attività come l’addestramento di un modello di intelligenza artificiale per tradurre il discorso dal vivo in diretta da una lingua all’altra o per generare automaticamente sottotitoli video.

Prestazioni più veloci significa che gli sviluppatori di IA possono affrontare compiti più impegnativi come i veicoli autonomi e accelerare la loro sperimentazione, ma una delle maggiori aree di miglioramento è il linguaggio di elaborazione.

Linley Gwennap, analista di TechInsights, afferma che l’H100, insieme agli strumenti software di Nvidia, consolida la sua posizione nel mercato dei processori AI. “Nvidia domina i suoi concorrenti”, ha scritto Gwennap in un rapporto ad aprile.

Pindrop, un cliente Nvidia di lunga data che utilizza l’analisi vocale basata sull’intelligenza artificiale per aiutare i rappresentanti del servizio clienti ad autenticare i clienti legittimi e individuare i truffatori, afferma che i costanti progressi del produttore di chip gli hanno permesso di espandersi all’identificazione di deepfake audio. I deepfake sono sofisticate simulazioni al computer che possono essere utilizzate per perpetrare frodi o diffondere disinformazione.

“Non potremmo arrivarci se non avessimo l’ultima generazione di GPU Nvidia”, ha affermato Ellie Khoury, direttore della ricerca dell’azienda.

Nvidia H100: come funziona e quanto è potente davvero?

L’addestramento del loro sistema di intelligenza artificiale implica l’elaborazione di un’enorme quantità di informazioni, inclusi i dati audio di 100.000 voci, ognuna manipolata in diversi modi per simulare cose come chiacchiere in sottofondo e cattive connessioni telefoniche. Ecco perché i progressi di H100, come la memoria espansa e l’elaborazione più rapida, sono importanti per i clienti di IA.

Nvidia stima che il suo H100 sia complessivamente sei volte più veloce del predecessore A100 lanciato dall’azienda due anni fa. Un’area importante che sicuramente avvantaggia è l’elaborazione del linguaggio naturale. Conosciuto anche come NLP, il dominio AI aiuta i computer a capire il tuo discorso, riassumere documenti e tradurre le lingue, tra le altre attività.

Nvidia è un giocatore forte nella PNL, un campo all’avanguardia dell’IA. Il sistema Palm AI di Google può separare causa ed effetto in una frase, scrivere codice di programmazione, spiegare barzellette e giocare al gioco del film “Emoji”. Ma le GPU flessibili di Nvidia sono apprezzate dai ricercatori. Ad esempio, Meta, la società madre di Facebook, questa settimana ha rilasciato gratuitamente una sofisticata tecnologia NLP per accelerare la ricerca sull’IA e funziona su 16 GPU Nvidia.

Con l’H100, i ricercatori NLP e gli sviluppatori di prodotti possono lavorare più velocemente, ha affermato Ian Buck, vicepresidente del gruppo di calcolo iperscalabile e ad alte prestazioni di Nvidia.

“Ciò che ha richiesto mesi dovrebbe richiedere meno di una settimana.”

L’H100 offre un grande passo avanti nei trasformatori, una tecnologia AI creata da Google in grado di valutare l’importanza del contesto attorno alle parole e rilevare sottili relazioni tra le informazioni in un’area e nell’altra.

I dati come foto, voce e testo utilizzati per addestrare l’IA spesso devono essere accuratamente etichettati prima dell’uso, ma i modelli di intelligenza artificiale basati su trasformatore possono utilizzare dati grezzi come vasti tratti di testo sul Web, ha affermato Aidan Gomez, co-fondatore dell’avvio del linguaggio AI Coerente.

“Legge Internet. Consuma Internet”, ha detto Gomez, quindi il modello di intelligenza artificiale trasforma quei dati grezzi in informazioni utili che catturano ciò che gli umani sanno del mondo. I trasformatori di effetti “hanno portato avanti la mia sequenza temporale di decenni” quando si tratta del ritmo del progresso dell’IA.

Tutti ne trarremo vantaggio dalla capacità dell’H100 di accelerare la ricerca e lo sviluppo dell’IA, ha affermato Hang Liu, assistente professore presso lo Stevens Institute of Technology. Amazon può individuare più recensioni false, i produttori di chip possono disporre meglio i circuiti dei chip e un computer può trasformare le tue parole in cinese mentre le parli, ha detto.

“In questo momento l’IA sta completamente rimodellando quasi tutti i settori della vita commerciale”.