San Jose, California, 22 giugno, Inspur, un importante data center e fornitore di soluzioni AI full-stack rilascia server NF5468M6 e NF5468A5 AI che supportano la più recente GPU Nvidia Ampere A100 PCle Gen 4, fornendo agli utenti AI di tutto il mondo, l’ultima piattaforma informatica AI con prestazioni e flessibilità superiori.

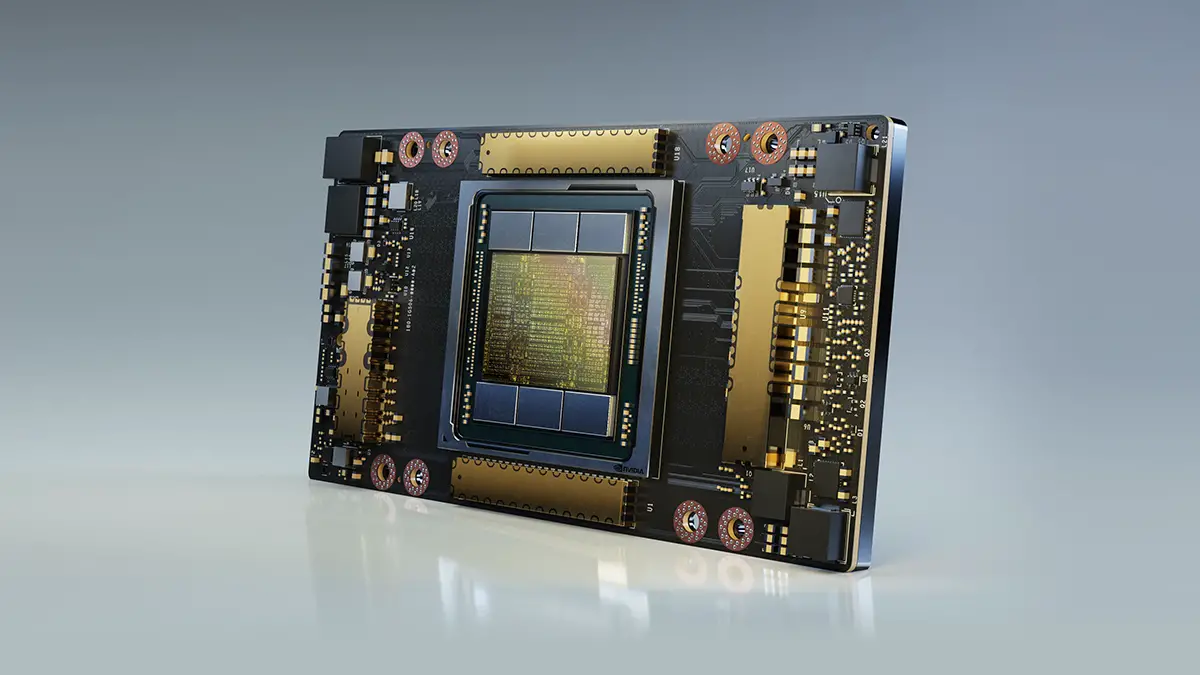

Nvidia aveva già annunciato la sua prossima generazione di GPU Ampere A100 il mese scorso, ma quella era la versione SXM4 della scheda grafica destinata alle applicazioni scientifiche e dei data center. Ora, l’azienda annuncia la variante Nvidia Ampere A100 PCle 4.0 della GPU, che viene fornita con la stessa GPU e memoria, ma è qui che finiscono le somiglianze.

Naturalmente, la differenza più notevole è la sua connettività. Lo slot PCIe 4.0 su questa scheda grafica la rende molto più flessibile rispetto alla variante SXM, in quanto può essere inserita nella maggior parte dei PC anziché in sistemi appositamente progettati. Ciò consente un facile aggiornamento delle infrastrutture server esistenti o l’installazione in workstation per uso scientifico, inoltre consente a molti integratori di sistemi di integrare facilmente la Nvidia Ampere A100 PCle nei propri sistemi.

Proprio come il Pascal P100 e Volta V100 prima, la GPU Ampere A100 era destinata a ottenere una variante PCIe prima o poi. Ora NVIDIA ha annunciato che l’acceleratore GPU Nvidia Ampere A100 PCIe è disponibile per una serie diversificata di casi d’uso con un sistema che va da una singola GPU PCIe A100, fino a server che utilizzano due schede contemporaneamente attraverso i 12 canali NVLINK che forniscono 600 GB / s di interconnessione larghezza di banda.

Nvidia Ampere A100 PCle: specifiche tecniche

In termini di specifiche, l’acceleratore GPU A100 PCIe non cambia molto in termini di configurazione di base. La GPU Nvidia Ampere A100 PCle mantiene le specifiche che avrai potuto vedere sulla variante da 400 W con 6912 core CUDA disposti in 108 unità SM, 432 Tensor Core e 40 GB di memoria HBM2 che offre la stessa larghezza di banda di memoria di 1,55 TB / s (arrotondata a 1,6 TB /S). La differenza principale può essere vista nel TDP che è valutato a 250 W per la variante PCle mentre la variante standard viene fornita con un TDP a 400 W.

Ora potrai intuire che la scheda dovrebbe avere un clock inferiore per compensare l’input TDP inferiore, ma NVIDIA ha fornito i numeri di picco di calcolo e quelli rimangono inalterati per la variante PCIe. Le prestazioni FP64 sono ancora valutate a 9.7 / 19.5 TFLOP, le prestazioni FP32 sono valutate a 19.5 / 156/312 TFLOP (Sparsity), le prestazioni FP16 sono valutate a 312/624 TFLOP (Sparsity) e INT8 è valutato a 624/1248 TOPs (Sparsity ).

Secondo l’azienda, l’acceleratore Nvidia Ampere A100 PCle può offrire il 90% delle prestazioni della scheda A100 HGX (400 W) nelle migliori applicazioni server. Ciò è dovuto principalmente al minor tempo necessario alla scheda per svolgere tali compiti, tuttavia, in situazioni complesse che richiedevano capacità della GPU sostenute, la GPU può offrire ovunque dal 90% al 50% delle prestazioni della GPU da 400 W nei casi più estremi. NVIDIA ha dichiarato che il calo del 50% sarà molto raro e solo alcune attività possono spingere la scheda a tale estensione.

Nvidia Ampere A100 PCle: è tutto oro quel che luccica?

“L’adozione di GPU NVIDIA Ampere A100 PCle nelle offerte dei principali produttori di server sta superando tutto ciò che abbiamo visto in precedenza”

Questo è quanto ha dichiarato Ian Buck, VP e GM di Accelerated Computing presso NVIDIA, per poi aggiungere:

“La vastità dei server NVIDIA A100 dei nostri partner garantisce che i clienti possano scegliere le opzioni migliori per accelerare i loro data center per un elevato utilizzo e un basso costo totale di proprietà.”

Ma questa flessibilità avrà un costo. La variante PCIe 4 della GPU Ampere A100 ha un TDP significativamente più basso di 250 W rispetto al TDP da 400 W dell’SXM. Nvidia afferma che ciò comporta una riduzione delle prestazioni del 10% nei carichi di lavoro con GPU singola. Tuttavia, il ridimensionamento multi-GPU è limitato a sole due GPU tramite NVLink, dove NVSwitch supporta fino a otto GPU.

Per i carichi di lavoro distribuiti, Nvidia afferma che la penalità prestazionale (osservando otto GPU) è fino al 33%.

Sembra che gran parte della potenza aggiuntiva TDP sulla variante SXM vada alle comunicazioni tra GPU, in base alla differenza di prestazioni del 10% per una singola GPU. 400 W è anche il limite massimo di potenza, quindi la GPU potrebbe non utilizzare così tanto in alcuni carichi di lavoro. Si noti che l’erogazione di energia è anche molto più semplice con SXM, poiché l’alimentazione arriva attraverso il connettore mezzanino. Al contrario, i modelli PCIe ricevono fino a 75 W di potenza dallo slot x16, con alimentazione aggiuntiva proveniente da connettori PEG a 8 o 6 pin.

Potenza e TDP a parte, le schede grafiche sono quasi identiche. La stessa GPU Ampere viene utilizzata con i suoi core CUDA 6912, facendo misurare la GPU in un impressionante quadrato di 826 mm, nonostante sia stata fabbricata con il processo a 7 nm. La GPU è ancora affiancata da sei stack HBM2 che offrono ben 40 GB di memoria ultraveloce.

Nvidia Ampere A100 PCle: lista partner

L’adozione su larga scala è già stata resa possibile da NVIDIA e dai suoi partner server per il suddetto acceleratore GPU basato su PCIe –Nvidia Ampere A100 PCle– che include:

-

ASUS

offrirà l’ESC4000A-E10, che può essere configurato con quattro GPU PCIe A100 in un singolo server.

-

Atos

offre il suo sistema BullSequana X2415 con quattro GPU NVIDIA A100 Tensor Core.

-

Cisco

prevede di supportare GPU NVIDIA A100 Tensor Core nei suoi server Cisco Unified Computing System e nel suo sistema di infrastruttura iperconvergente, Cisco HyperFlex.

-

Dell Technologies

prevede di supportare GPU NVIDIA A100 Tensor Core attraverso i suoi server PowerEdge e soluzioni che accelerano i carichi di lavoro da bordo a core a cloud, così come supporta altri acceleratori, software e tecnologie GPU NVIDIA in una vasta gamma di offerte.

-

Fujitsu

sta portando le GPU A100 sulla sua linea di server PRIMERGY.

-

GIGABYTE

offrirà server G481-HA0, G492-Z50 e G492-Z51 che supportano fino a 10 GPU PCIe A100, mentre il server G292-Z40 ne supporta fino a otto.

-

HPE

supporterà le GPU PCIe A100 nel server HPE ProLiant DL380 Gen10 e, per i carichi di lavoro accelerati HPC e AI, nel sistema HPE Apollo 6500 Gen10.

-

Inspur

sta rilasciando otto sistemi NVIDIA A100, tra cui NF5468M5, NF5468M6 e NF5468A5 utilizzando GPU PCIe A100, NF5488M5-D, NF5488A5, NF5488M6 e NF5688M6 utilizzando NVLink a otto vie e NF5888.

-

Lenovo

supporterà le GPU PCIe A100 su sistemi selezionati, incluso il server Lenovo ThinkSystem SR670 AI-ready. Lenovo amplierà la disponibilità in tutto il portafoglio ThinkSystem e ThinkAgile in autunno.

-

One Stop Systems

offrirà il suo sistema di espansione PCIe OSS 4UV Gen 4 con un massimo di otto GPU NVIDIA A100 PCIe per consentire ai clienti AI e HPC di scalare i propri server Gen 4.

-

Quanta / QCT

offrirà diversi sistemi server QuantaGrid, tra cui D52BV-2U, D43KQ-2U e D52G-4U che supportano fino a otto GPU NVIDIA A100 PCIe.

-

Supermicro

offrirà il suo sistema 4U A + GPU, che supporta fino a otto GPU NVIDIA A100 PCIe e fino a due slot di espansione PCI-E 4.0 aggiuntivi ad alte prestazioni insieme ad altri server GPU 1U, 2U e 4U.

Nvidia Ampere A100 PCle: data di uscita

NVIDIA non ha ancora annunciato alcuna data di rilascio o prezzo per la Nvidia Ampere A100 PCle, ma considerando che la GPU Tensor Core A100 (400 W) è già stata spedita dal suo lancio, la Nvidia Ampere A100 PCle (250 W) seguirà presto i suoi passi.

Per i giocatori tra di noi, dovremo aspettare ancora un po’ per accedere alla bontà PCI-Express 4.0 di Nvidia. Prevedo che le schede grafiche Ampere per i consumatori presenteranno il nuovo standard di connettività, ma non prevedo di vedere le schede Ampere GeForce RTX 3000 fino a settembre. Dato che i leaks stanno arrivando più velocemente di quanto possiamo scrivere su di loro, vedremo sicuramente nuove GPU entro la fine dell’anno.