Cerebras Systems ha presentato il suo nuovo processore Wafer Scale Engine 2 (Cerebras WSE-2) con un record di 2,6 trilioni di transistor e 850.000 core ottimizzati per AI.

Costruito per attività di supercalcolo è la seconda volta dal 2019 che Cerebras, con sede a Los Altos, in California, ha svelato un chip che è fondamentalmente un intero wafer.

I produttori di chip normalmente tagliano un wafer da un lingotto di silicio del diametro di 12 pollici per elaborarlo in una fabbrica di chip, poi una volta elaborato, il wafer viene tagliato in centinaia di chip separati che possono essere utilizzati nell’hardware elettronico.

Sebbene questi siano gli standard, Cerebras, fondato dal fondatore di SeaMicro Andrew Feldman, prende quel wafer e ne ricava un unico, enorme chip, ed ogni pezzo del chip, soprannominato core, è interconnesso in modo sofisticato ad altri core.

Le interconnessioni sono progettate per mantenere tutti i core funzionanti ad alta velocità in modo che i transistor possano lavorare insieme come uno solo.

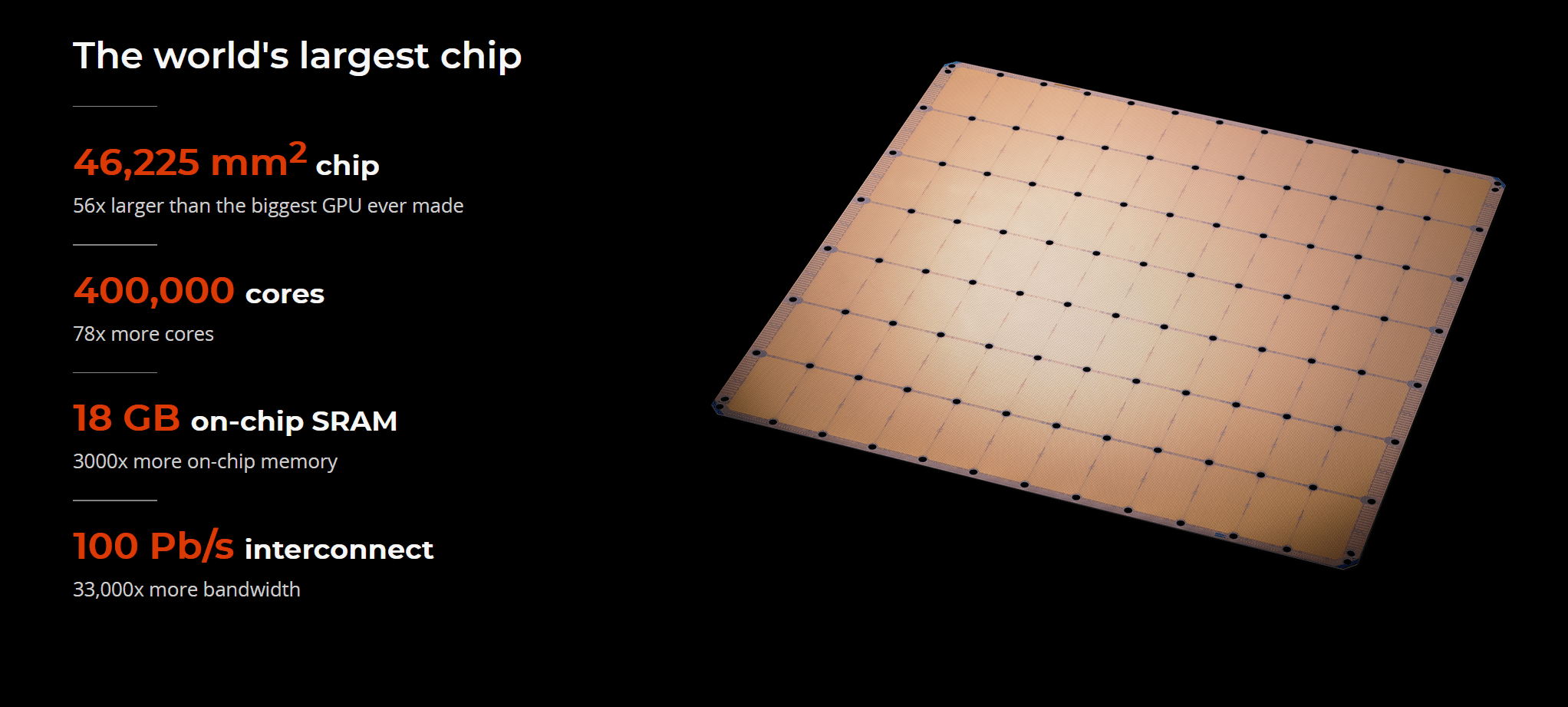

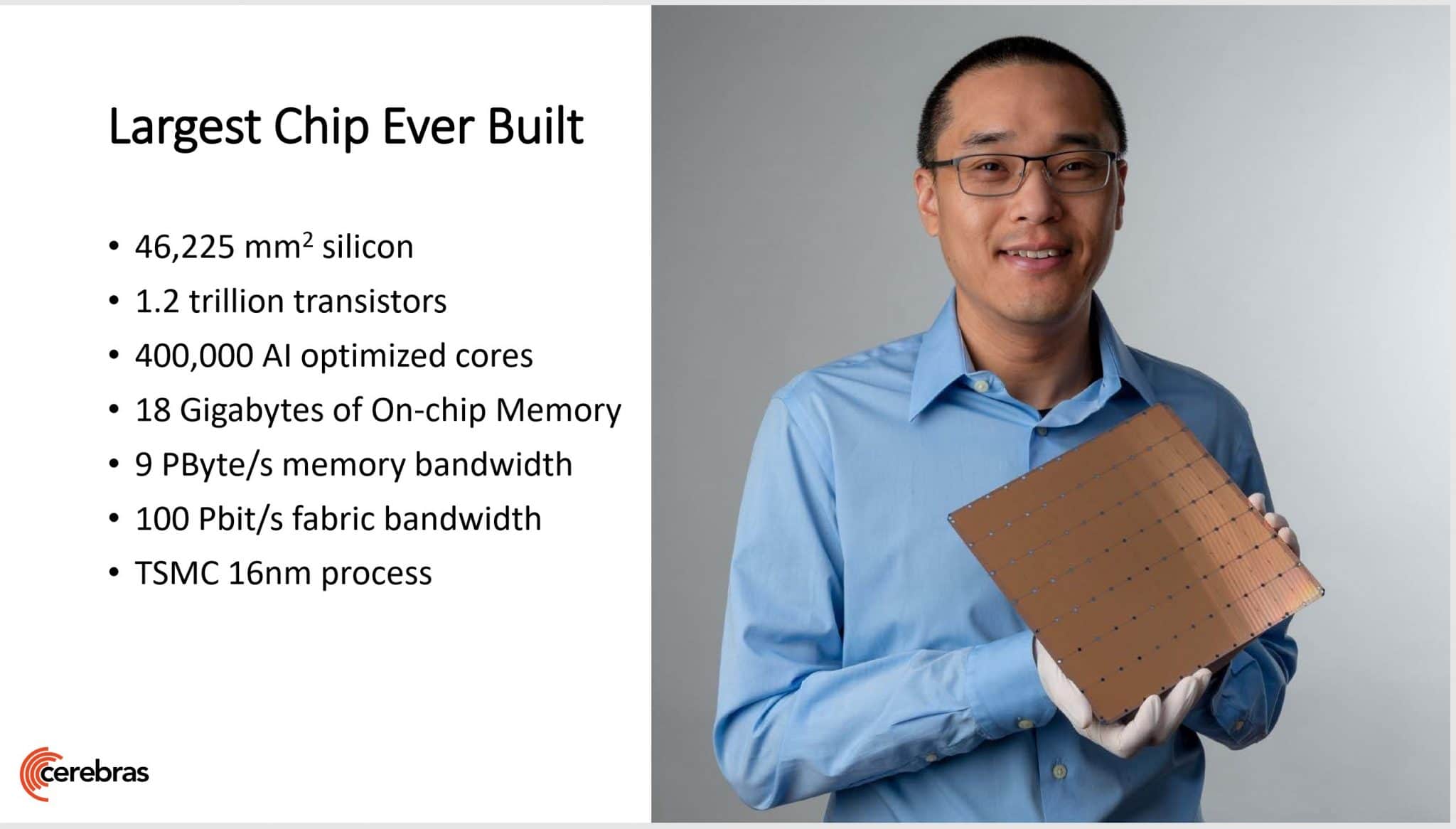

Nel 2019, Cerebras ha avuto modo di montare 400.000 core e 1,2 miliardi di transistor su un chip wafer, il CS-1, il quale fu costruito con un processo di fabbricazione a 16 nanometri, invece il nuovo Cerebras WSE-2 è costruito con un processo a 7 nanometri di fascia alta, il che significa che la larghezza tra i circuiti è di sette miliardesimi di metro.

Con tale miniaturizzazione, Cerebras può stipare molti più transistor nello stesso wafer da 12 pollici, taglia quel wafer circolare in un quadrato di otto pollici per otto pollici e spedisce il dispositivo in quella forma, ha detto Feldman.

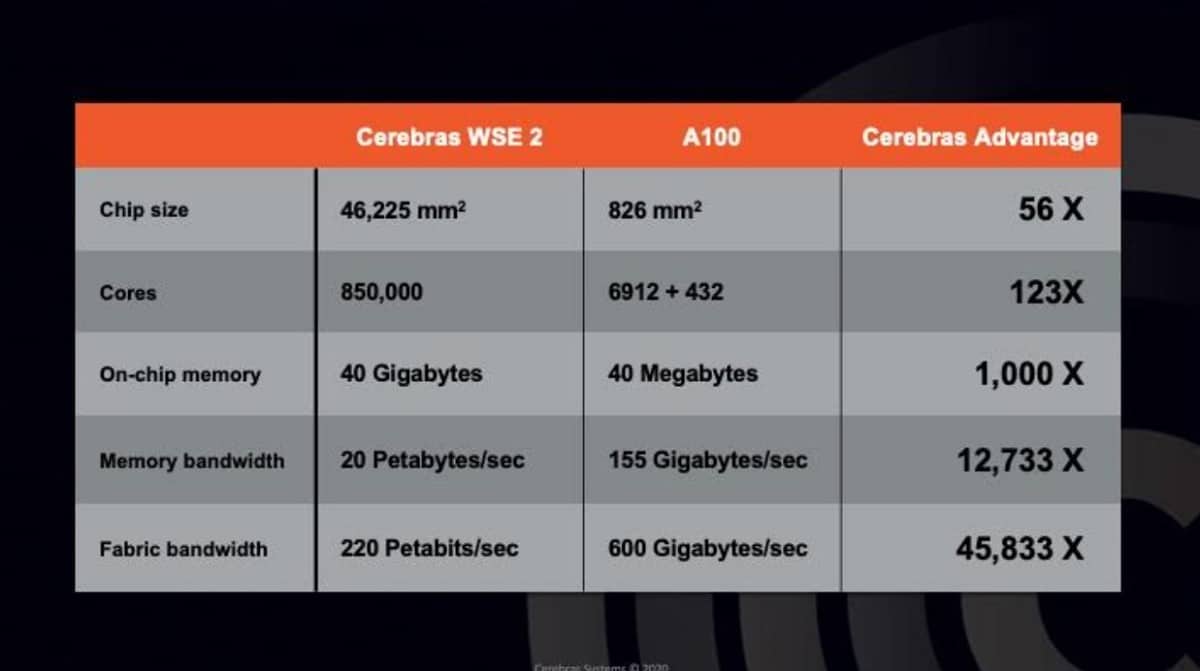

“Abbiamo 123 volte più core e 1.000 volte più memoria su chip e 12.000 volte più larghezza di banda di memoria e 45.000 volte più larghezza di banda fabric.

Siamo stati aggressivi nel ridimensionare la geometria e abbiamo apportato una serie di miglioramenti alla microarchitettura”.

ha aggiunto Feldman in un’intervista a VentureBeat.

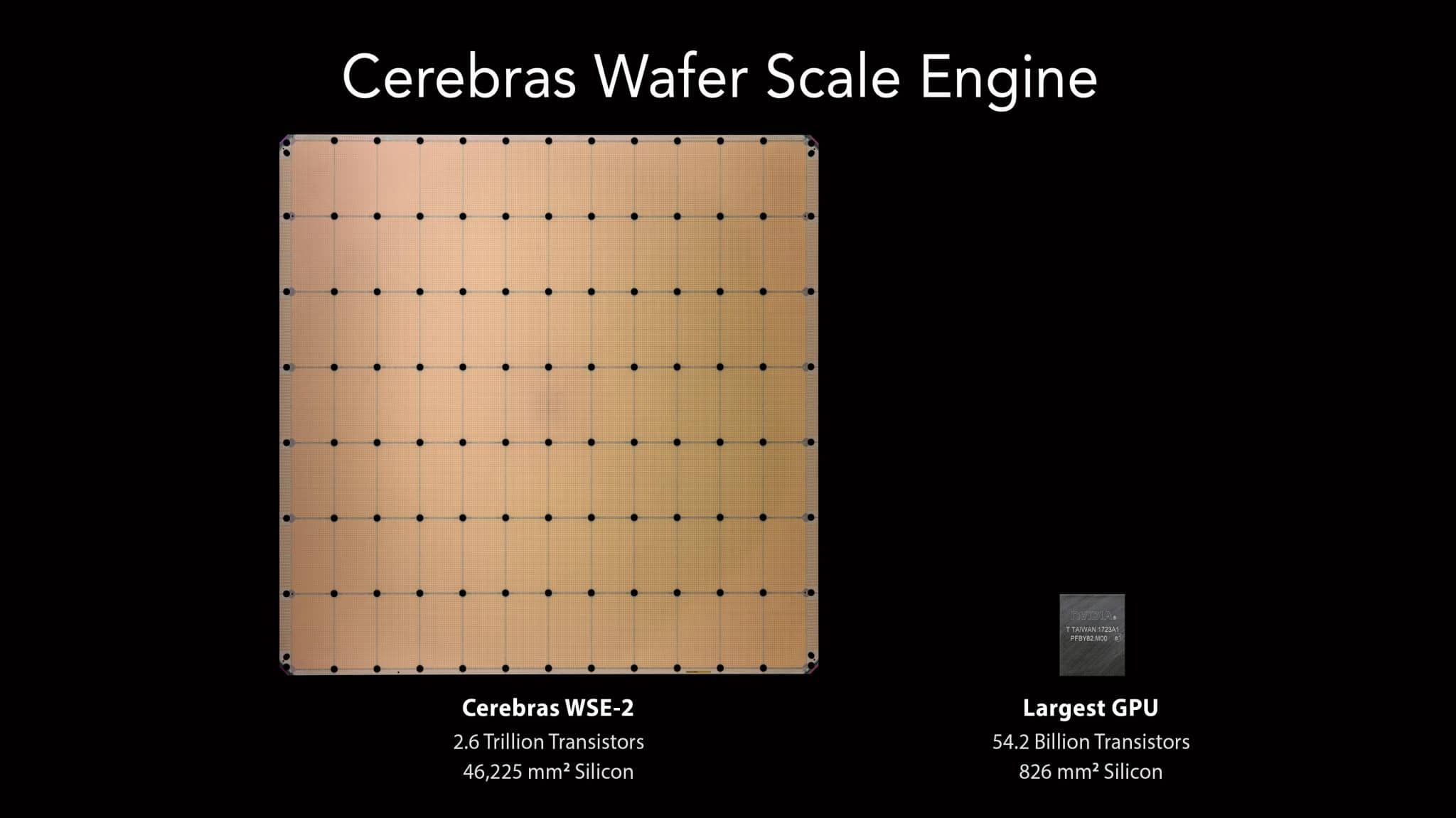

Ora il chip Cerebras WSE-2 ha più del doppio dei core e dei transistor, in confronto, la più grande unità di elaborazione grafica (GPU) ha solo 54 miliardi di transistor, 2,55 trilioni di transistor in meno rispetto al Cerebras WSE-2.

Il Cerebras WSE-2 ha anche un numero di core 123 volte superiore e una memoria su chip ad alte prestazioni 1.000 volte superiore rispetto ai concorrenti GPU, inoltre molti dei core Cerebras sono ridondanti nel caso in cui una parte fallisca.

“Questo è un grande risultato, soprattutto se si considera che il terzo chip più grande del mondo è 2,55 trilioni di transistor più piccolo del Cerebras WSE-2”

ha affermato Linley Gwennap, principale analista di The Linley Group, in un comunicato.

Feldman ha scherzato a metà sul fatto che questo dovrebbe dimostrare che Cerebras non è un pony con un solo trucco.

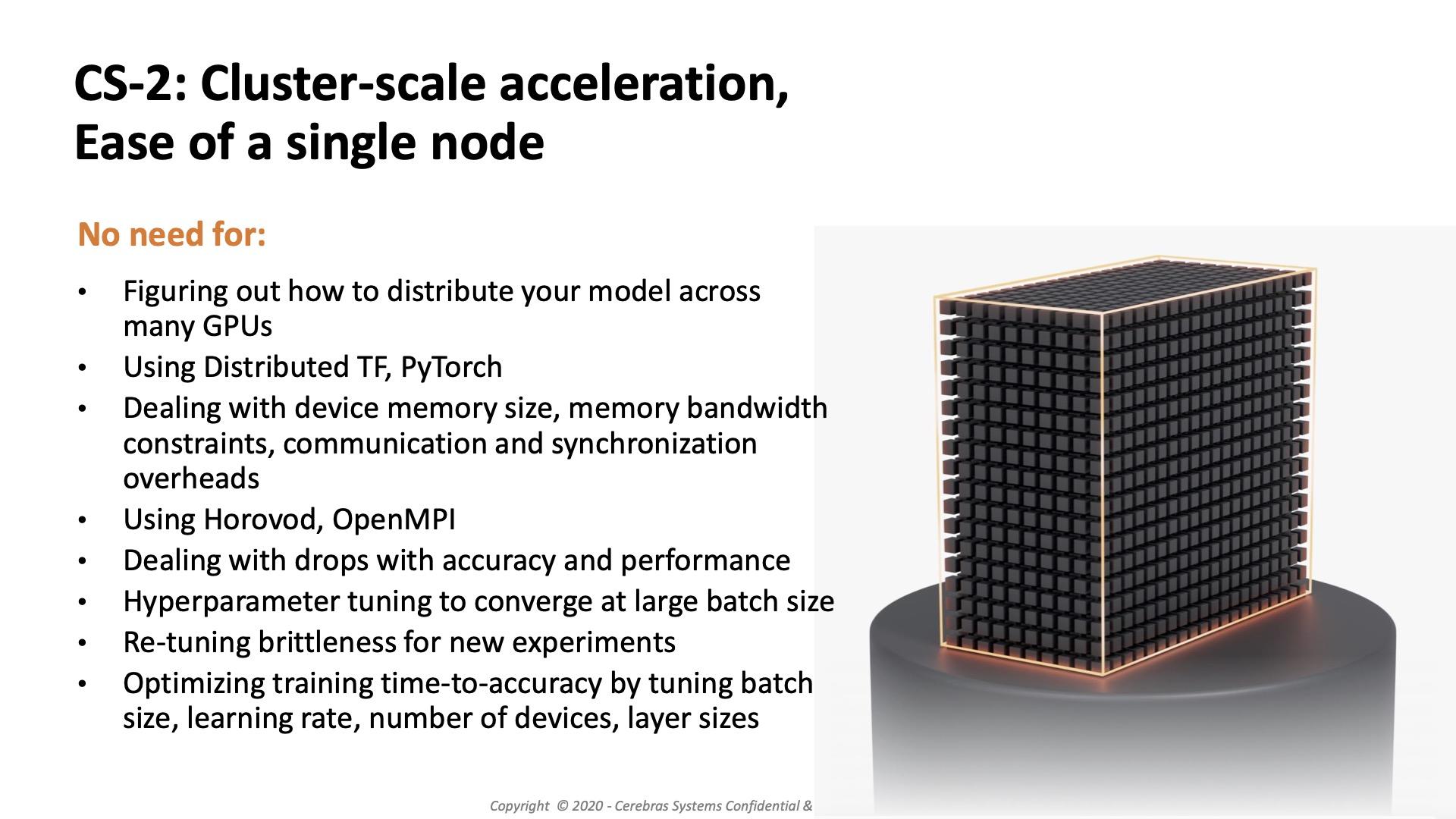

“Ciò che questo evita è tutta la complessità di cercare di collegare insieme tante piccole cose.

Quando devi costruire un cluster di GPU, devi diffondere il tuo modello su più nodi. Devi affrontare le dimensioni della memoria del dispositivo, i vincoli della larghezza di banda della memoria e i costi di comunicazione e sincronizzazione”.

ha detto Feldman.

La funzione di Cerebras WSE-2

Il Cerebras WSE-2 alimenterà il Cerebras CS-2, il computer AI più veloce del settore, progettato e ottimizzato per 7 nanometri e oltre.

Prodotto dal produttore a contratto TSMC, il Cerebras WSE-2 più che raddoppia tutte le caratteristiche prestazionali del chip (numero di transistor, numero di core, memoria, larghezza di banda della memoria e larghezza di banda del fabric) rispetto al WSE di prima generazione.

Il risultato è che in ogni metrica delle prestazioni, il Cerebras WSE-2 è più grande e più performante di qualsiasi GPU concorrente sul mercato, ha affermato Feldman.

TSMC ha messo il primo chip WSE-1 in un museo di innovazione per la tecnologia dei chip a Taiwan.

“Cerebras fornisce i core promessi, ciò che l’azienda sta offrendo è più simile a più cluster su un chip. Sembra dare a Nvidia una corsa per i suoi soldi, ma non esegue CUDA grezzo.

Questo è diventato in qualche modo uno standard de facto. Le soluzioni Nvidia sono più flessibili e possono adattarsi a quasi tutti gli chassis dei server “

ha detto Patrick Moorhead, analista di Moor Insights & Strategy.

Con ogni componente ottimizzato per il lavoro di intelligenza artificiale, il CS-2 offre più prestazioni di elaborazione con meno spazio e meno potenza rispetto a qualsiasi altro sistema.

A seconda del carico di lavoro, dall’intelligenza artificiale all’elaborazione ad alte prestazioni, CS-2 offre prestazioni centinaia o migliaia di volte superiori rispetto alle alternative legacy e lo fa con una frazione del consumo energetico e dello spazio.

Un singolo CS-2 sostituisce cluster di centinaia o migliaia di unità di elaborazione grafica (GPU) che consumano dozzine di rack, utilizzano centinaia di kilowatt di potenza e impiegano mesi per configurare e programmare: con un’altezza di soli 26 pollici, il CS-2 si adatta a un terzo di un rack per data center standard.

“Ovviamente, ci sono aziende ed entità interessate alla soluzione su scala wafer di Cerebras per grandi set di dati, ma ci sono molte più opportunità a livello aziendale per i milioni di altre applicazioni di intelligenza artificiale e ancora opportunità oltre a ciò che Cerebras potrebbe gestire, motivo per cui Nvidia ha i supercomputer SuprPod e Selene”.

ha affermato Jim McGregor, principale analista di Tirias Research, in una e-mail, per poi aggiungere:

“Devi anche ricordare che Nvidia sta prendendo di mira tutto, dalla robotica AI con Jenson ai supercomputer.

Cerebras è più una piattaforma di nicchia, ci vorranno alcune opportunità ma non corrisponderà all’ampiezza di ciò che Nvidia punta, inoltre Nvidia sta vendendo tutto ciò che può costruire “.

L’azienda ha dato prova di sé consegnando la prima generazione ai clienti e, nell’ultimo anno, questi ultimi hanno implementato Cerebras WSE e CS-1, e tra questi troviamo:

- l’Argonne National Laboratory,

- il Lawrence Livermore National Laboratory,

- il Pittsburgh Supercomputing Center (PSC) per il suo supercomputer Neocortex AI,

- EPCC,

- il centro di supercalcolo dell’Università di Edimburgo,

- il leader farmaceutico GlaxoSmithKline

- Dispositivi elettronici di Tokyo;

- e altri ancora.

A lodare il Cerebras WSE-2 anche al di fuori delle mura aziendali, sono stati quelli dell’Argonne National Laboratory e quelli di GlaxoSmithKline.

Kim Branson, vicepresidente senior di GlaxoSmithKline, ha affermato in una dichiarazione che l’azienda ha aumentato la complessità dei modelli di encoder che genera riducendo i tempi di formazione di 80 volte, mentre ad Argonne, il chip viene utilizzato per la ricerca sul cancro e ha ridotto di oltre 300 volte i tempi di risposta dell’esperimento sui modelli di cancro.

“Per quanto riguarda la scoperta di farmaci, abbiamo altre vittorie che annunceremo nel prossimo anno nella produzione pesante e farmaceutica, biotecnologica e militare”

ha detto Feldman.

I nuovi Cerebras WSE-2 verranno spediti nel terzo trimestre, con Feldman che ha affermato che la società ora ha più di 300 ingegneri, con uffici nella Silicon Valley, Toronto, San Diego e Tokyo.